Découvrez-la en avant-première – quelques réglages en cours – via l’adresse :

http://www.speedfirenetwork.net/stockagenews

Filed under: Actualités | Tagged: stockagenews | Leave a comment »

Découvrez-la en avant-première – quelques réglages en cours – via l’adresse :

http://www.speedfirenetwork.net/stockagenews

Filed under: Actualités | Tagged: stockagenews | Leave a comment »

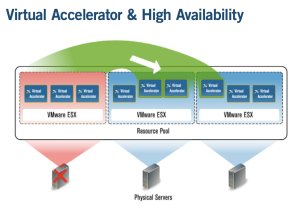

Lancé au printemps dernier, les accélérateurs virtuels d’Expand Neworks sont retenus par les fournisseurs de services managés IPstar dans la zone Asie-Pacifique et Clear Channel Satellite sur les continents Américains.

Pour Christian Honoré, directeur général, cet accueil favorable correspond à une tendance : les prestataires de services consolident leurs ressources de stockage et leurs serveurs autour de grands réseaux SAN centraux. Ce phénomène s’accompagne d’un environnement virtualisé dans le Data center, pour améliorer la disponibilité des services tout en réduisant le nombre de serveurs physiques à administrer.

Pour Christian Honoré, directeur général, cet accueil favorable correspond à une tendance : les prestataires de services consolident leurs ressources de stockage et leurs serveurs autour de grands réseaux SAN centraux. Ce phénomène s’accompagne d’un environnement virtualisé dans le Data center, pour améliorer la disponibilité des services tout en réduisant le nombre de serveurs physiques à administrer.

« Nos clients regroupent fréquemment leurs services autour de platefomes VMware, Xen ou Hyper-V, via des serveurs à lames ou non. Ces serveurs génériques prennent en charge le code d’Expand, divisant par deux ou par trois le coût de l’optimisation WAN », précise-t-il. Quelques précisions sur les tarifs de l’accélération virtuelle d’Expand Networks dans cet article StockageNews.

Un serveur Intel peut prendre en charge plusieurs copies du logiciel, sous VMware, transformant ainsi la plateforme en cluster d’optimisation WAN. Grâce à cette mise en grappe, une agrégation de liens étendus devient possible, avec analyse et compression de tout ou partie du trafic vers les liens étendus agrégés. Cela permet de traiter certaines application en priorité, via la gestion de QoS intégrée dans le logiciel. En outre, une bascule à chaud est permise entre les caches répliquées en miroir, de façon permanente, via le SAN ou au travers du stockage en place dans le site central.

Clear Channel Satellite exploite ces facultés pour optimiser ses services satellitaires managés appréciés des agences gouvernementales et des diffuseurs TV. Son offre XtremeSat Plus (déployées sur les deux continents américains) retient l’accélérateur virtuel d’Expand Networks pour offrir des applications évolutives, à haut débit. Un des critères pour lesquels Clear Channel Satellite a choisi la solution Virtual Accelerator d’Expand Networks a été son intégration dans l’infrastructure virtuelle en place. Cette solution permet d’ajuster facilement les services, à la demande, en ajoutant simplement de nouvelles instances de l’accélérateur virtuel, sur la plateforme existante.

Clear Channel Satellite exploite ces facultés pour optimiser ses services satellitaires managés appréciés des agences gouvernementales et des diffuseurs TV. Son offre XtremeSat Plus (déployées sur les deux continents américains) retient l’accélérateur virtuel d’Expand Networks pour offrir des applications évolutives, à haut débit. Un des critères pour lesquels Clear Channel Satellite a choisi la solution Virtual Accelerator d’Expand Networks a été son intégration dans l’infrastructure virtuelle en place. Cette solution permet d’ajuster facilement les services, à la demande, en ajoutant simplement de nouvelles instances de l’accélérateur virtuel, sur la plateforme existante.

Filed under: Actualités, Tendances, Terrain | Tagged: accélération, optimisation, services managés, virtualisation, WAN | Leave a comment »

Avec deux réseaux SAN distants de 40 kilomètres – reliés par fibre optique le long de l’autoroute de la Maurienne – la virtualisation des ressources de stockage apporte un vrai plus à la SFTRF, la Société Française du Tunnel Routier du Fréjus : « Nous utilisons la solution logicielle de Datacore pour mutualiser nos ressources de stockage hétérogènes et rendre l’ensemble homogène », explique Jean-Marc Couvert, Chef du Service Informatique et Bureautique de la SFTRF.

Avec deux réseaux SAN distants de 40 kilomètres – reliés par fibre optique le long de l’autoroute de la Maurienne – la virtualisation des ressources de stockage apporte un vrai plus à la SFTRF, la Société Française du Tunnel Routier du Fréjus : « Nous utilisons la solution logicielle de Datacore pour mutualiser nos ressources de stockage hétérogènes et rendre l’ensemble homogène », explique Jean-Marc Couvert, Chef du Service Informatique et Bureautique de la SFTRF.

Cette approche permet de réduire les coûts du plan de reprise d’activités, imaginé avec l’intégrateur Flowline. En effet, la réplication des données s’effectue désormais par niveaux de stockage, entre les deux SAN, en mode asynchrone ou synchrone. L’adjonction de serveurs virtualisés sous VMware facilite la bascule sur l’un ou l’autre réseau SAN, sans délai de coupure. « Auparavant, les éditeurs exigeaient des licences très onéreuses pour la mise en grappe de leurs serveurs de données. La virtualisation ne justifie plus l’investissement dans de coûteux clusters. Depuis, Oracle et Microsoft sont revenus à la réplication entre serveurs de façon native, ce qui nous permet maintenant d’utiliser ce qu’il y a de mieux dans chaque application ».

Au total, douze serveurs physiques Dell sont répartis entre les deux sites de Modane et Sainte-Marie, ces clusters virtualisés soutenant (via une quarantaine de VM) les applications Oracle 9i, les services RH, l’intranet et l’ERP Sage X3 sous Windows Server 2003 vers lequel toutes les transactions remontent. En outre, la SFTRF retient l’application Vmotion pour ses migrations. La baie CX 300 d’EMC du site principal se reflète dans une baie CX 320 sur le site de secours. Les utilisateurs se connectent à leurs ressources privées et accèdent, de façon transparente, à l’un ou l’autre des deux centres informatiques, quel que soit le moyen de connexion.

L’administrateur manipule, en fait, des volumes logiques, recomposés de façon dynamique et alloués à une application reposant sur une machine virtuelle VMware. « C’est une évolution que l’on imaginait pas il y a cinq ans et qui simplifie considérablement la gestion du système d’information. Elle est imperceptible pour les utilisateurs qui ne subissent plus d’inactivités durant les opérations de maintenance. En cas de besoin, grâce aux images de serveurs et de postes de travail, chacun dispose d’une nouvelle machine très rapidement opérationnelle », conclut-il.

Filed under: Tendances, Terrain | Tagged: réplication, SAN, virtualisation | Leave a comment »

Au prix moyen de 70 KE – pouvant grimper jusqu’à 150 KE – Hitachi Data Systems offre une baie NAS à mettre en grappe pour préserver les fichiers non structurés de l’entreprise. Multi-support et multi-protocole, elle se décline en deux modèles offrant des pools d’archives, de disques SATA, SAS ou Fibre Channel, un accès SAN et une interface iSCSI (4096 LUNs). Les disques intégrés proviennent de deux sources essentiellement – Seagate et Hitachi – pour une volumétrie maximale de 256 To de système de fichiers.

Michel Alliel, directeur des solutions HDS France, précise les éléments qui distinguent ces nouvelles baies de stockage des modèles FAS du rival NetApp, actuel leader du segment de marché : « Les modèles 3080 et 3090 restructurent notre gamme en s’intégrant dans les environnements virtualisés VMware, en soutien des données des plates-formes de virtualisation. Ils sont compacts (format 3U) et apportent 30 à 40% de vitesse de calcul supplémentaire grâce aux circuits Asic spécialisés, là où NetApp retient des processeurs x86 ». Ce choix permettrait à HDS de servir les fichiers de 64 serveurs virtuels distincts, avec un débit de plusieurs dizaines de gigabits par seconde, à supposer que les interfaces et les commutateurs du réseau suivent.

Les performances des deux nouvelles unités NAS restent étroitement liées au système de fichiers à base de classes de stockage. Hérité du haut de gamme de la marque japonaise, ce système autorise un archivage multisegment rapide. De quoi parlons-nous ici ? Non pas d’une sur-couche de gestion du stockage, type HSM, mais bien d’un placement automatique des fichiers sur des pools de disques distincts, en fonction des types de fichiers et de leur importance pour l’entreprise.

Michel Alliel, directeur des solutions HDS France, précise les éléments qui distinguent ces nouvelles baies de stockage des modèles FAS du rival NetApp, actuel leader du segment de marché : « Les modèles 3080 et 3090 restructurent notre gamme en s’intégrant dans les environnements virtualisés VMware, en soutien des données des plates-formes de virtualisation. Ils sont compacts (format 3U) et apportent 30 à 40% de vitesse de calcul supplémentaire grâce aux circuits Asic spécialisés, là où NetApp retient des processeurs x86 ». Ce choix permettrait à HDS de servir les fichiers de 64 serveurs virtuels distincts, avec un débit de plusieurs dizaines de gigabits par seconde, à supposer que les interfaces et les commutateurs du réseau suivent.

Les performances des deux nouvelles unités NAS restent étroitement liées au système de fichiers à base de classes de stockage. Hérité du haut de gamme de la marque japonaise, ce système autorise un archivage multisegment rapide. De quoi parlons-nous ici ? Non pas d’une sur-couche de gestion du stockage, type HSM, mais bien d’un placement automatique des fichiers sur des pools de disques distincts, en fonction des types de fichiers et de leur importance pour l’entreprise.

Par exemple, les documents bruts de la suite bureautique sont sauvés sur des disques rapides (SAS ou Fibre Channel) tandis que les documents sont générés en PDF – prêts à diffuser -, ils sont orientés vers un pool de disques SATA paré à l’archivage. Côté utilisateur, l’arborescence reste inchangée : tous les fichiers bruts et pdf restent visibles et regroupés dans le même répertoire réseau, indépendamment de la distribution en pools sous-jacente.

Autre point différentiant, l’agrégation des baies en grappe ; autrement dit, le clustering multi-noeuds. Il peut atteindre jusqu’à 8 têtes NAS chez HDS contre 2 chez NetApp. Cette granularité compte pour les plans de reprise d’activités, fondés sur deux ou plusieurs salles réparties géographiquement (lire l’article HDS interface les environnements virtuels). « L’évolutivité de nos baies est plus importante et nous évitons les silos de stockage de NetApp grâce à l’usage d’un nom commun dans un cluster multinoeud, ce global namespace permettant à tous les nœuds d’être vus comme une seule et même unité réseau », ajoute Michel Alliel.

Il ajoute que les snapshots et points de synchronisation des sauvegardes de machines virtuelles restent consistants, autorisant l’administrateur à remonter dans un flux d’images dans le temps, jusqu’à concurrence de 1024 snapshots.

Filed under: Actualités, Tendances | Tagged: iSCSI, NAS, PRA | Leave a comment »

« Notre panne majeure ? Nous l’avons connu il y a deux ans, sur une baie de stockage Raid 10 lorsque deux disques durs sont tombés en panne à moins d’une demi-heure d’intervalle… », se souvient Xavier Favre, le DSI de Yacast.

Le dispositif de secours n’a pas eu le temps de tout rattraper, d’autant qu’il s’agissait de deux disques maîtres du dispositif Raid. Heureusement, la restauration des données a permis un retour en arrière de 24 heures, mais les opérateurs ont dû ressaisir une journée de travail.

« A présent, nous avons besoin de configurations matérielles spécifiques avec du stockage en réseau réellement capable d’atteindre le débit de 1 Gbps. AlgOS Network réalise nos plateformes sur mesure : cela nous permet d’avoir des serveurs adaptés à nos besoins, économiques, qui ne consomment pas trop et restent administrables au quotidien », poursuit le DSI.

En pratique, le système d’informations doit servir deux métiers.  Yacast, créée en l’an 2000, est un fournisseur d’accès Internet hors norme. D’une part, il diffuse des flux multimédias vers Internet – via son propre réseau CDN – pour Lagardère, NRJ, Europe1 ou encore BFM ; l’entreprise retransmet aussi, à la demande des internautes équipés de boîtiers haut débit, les émissions de Canalplay, France24 ou LCP.

Yacast, créée en l’an 2000, est un fournisseur d’accès Internet hors norme. D’une part, il diffuse des flux multimédias vers Internet – via son propre réseau CDN – pour Lagardère, NRJ, Europe1 ou encore BFM ; l’entreprise retransmet aussi, à la demande des internautes équipés de boîtiers haut débit, les émissions de Canalplay, France24 ou LCP.

Et, d’autre part, l’institut de piges musicales et publicitaires surveille en temps réel quelques 34 radios et de 13 chaînes de TV.

Yacast regroupe des données disparates pour faire ses rapprochements multimédia et ses tableaux de bord, scrutant aussi les parutions en salles de cinéma, les affichages physiques et virtuels. Or chaque média retient sa propre technologie, là où Yacast doit conserver une seule nomenclature (1 annonceur, 1 marque, 1 produit) pour offrir un référentiel commun à tous les canaux.

L’évolution naturelle du réseau s’oriente vers une infrastructure dynamique avec des routes configurées par défaut. Une bascule de serveur est prévue en cas de problème (via LifeKeeper de SteelEye), lorsqu’un gestionnaire de données devient inaccessible par exemple. Le délai de reprise maximal ne dépasse pas 5 minutes, sans aucune perte de données tolérée. On frise la disponibilité continue.

« Lorsque plusieurs disques d’une baie RAID tombent en panne en même temps, les mécanismes de secours n’ont pas toujours le temps de tout reprendre. Ce cas de perte de données, certes rare, nous est arrivé. Nous devons donc y pallier. Nos interlocuteurs techniques chez AlgOS nous aident à concevoir un troisième serveur avec sa baie, l’ensemble étant placé sur un site distant ».

Comme les radios Internet sont dorénavant captées par les serveurs Yacast, qui reconnaissent les flux automatiquement grâce à des outils spécifiques, l’infrastructure ne tolère plus la moindre coupure, hors maintenance programmée. Les tableaux de bord, agrégats et suivis de campagnes deviennent ainsi parfaitement fidèles. A noter que cette pige en temps réel serait impossible à réaliser sans le soutien d’algorithmes innovants et d’équipements hautement disponibles.

Filed under: Reportages, Terrain | Tagged: baie, bascule, bases de données, disponibilité, Raid10, serveurs | Leave a comment »

Tom Georgens vient de gravir le dernier échelon. A 49 ans, le voici parvenu à la tête de NetApp, l’autre géant du stockage. En tant que nouveau pilote du comité de direction (CEO), il succède à Dan Warmenhoven qui a su transformer – en 15 ans – une PME de 45 salariés en un groupe international de 8000 salariés, gonflant son Chiffre d’Affaires de 10 millions de dollars à 3,4 milliards de dollars.

Un simple faux pas en terme de croissance externe – l’acquisition ratée de Data Domain, ravi par le rival EMC début juillet (lire les épisodes précédents) – ne saurait expliquer à lui-seul ce changement de cap.

D’autant que le premier trimestre fiscal 2010 vient de s’achever sur une hausse du bénéfice net de 49%, un bel exploit dans un marché mondial encore morose.

En fait, l’heure de la retraite n’a pas tout à fait sonné pour Dan Warmenhoven. Promu au poste de chairman, il va désormais piloter le comité d’actionnaires. A 59 ans, il pourra tempérer l’impatience des plus gourmands, misant déjà sur la vente de NetApp à un géant de l’informatique. Car, en 2010, l’industrie informatique sera encore en pleine mutation. Le paysage des fournisseurs du datacentre se transforme avec l’approche cloud computing – cette infrastructure virtuelle délivrée en tant que service est capable de séduire un nombre croissant de DAF. La transition, de taille, suppose de nouveaux équipements, de nouveaux logiciels, de nouveaux modèles économiques et de nouveaux contrats entre clients et prestataires-fournisseurs. Pourtant nul doute que cette nouvelle approche pèsera davantage sur le marché du stockage dans les prochaines années. Mais avec qui à sa tête ? Là est la question.

Filed under: Actualités, Tendances | Tagged: CEO, Cloud, netApp, résultats | Leave a comment »

Chaque seconde qui passe, d’ici à la fin de l’année 2010, 36,5 Tera-octets de données seront générées, estime IDC. Une portion significative de cette avalanche d’informations numériques viendra remplir vos disques durs et baies d’entreprise. D’où la capacité croissante des disques et baies prévues pour la fin 2009.

Chaque seconde qui passe, d’ici à la fin de l’année 2010, 36,5 Tera-octets de données seront générées, estime IDC. Une portion significative de cette avalanche d’informations numériques viendra remplir vos disques durs et baies d’entreprise. D’où la capacité croissante des disques et baies prévues pour la fin 2009.

La capacité des disques durs augmente afin de pouvoir stocker les contenus des PC, APN (appareils photo numérique) et autres camescopes dernier cri. Un nouveau ratio obsède actuellement les fabricants de supports magnétiques : c’est le rapport capacité/compacité qui permet au disque SATA de rejoindre les PC ultra-portables, disques externes et autres baladeurs multimédia en vogue actuellement.

La génération des disques SATA ultrafins de 1/2 To est déjà dépassée. Fin 2009, le Scorpio Blue de Western Digital proposera 1 To sur une hauteur de 12,5 mm pour un poids de 117 grammes, ses trois plateaux tournant à 5200 tours/minutes.

Pour sa part, le dernier né de Toshiba – il répond au doux nom de MKxx65GSX – s’efforce d’offrir 640 Go sur deux plateaux tournant à 5400 tours/minute, toujours dans un format de 2,5 pouces. Sa hauteur atteint 9,5 mm et son poids 98 grammes seulement.

Hitachi et Samsung ne devraient pas tarder à rétorquer avec des modèles au ratio capacité/compacité encore amélioré.

Au fait, de combien de Téra-octets aurez-vous besoin en 2010 à titre personnel ?

Filed under: Actualités, Tendances | Tagged: capacité, compacité, disque dur, portable | Leave a comment »

Le Conseil Général d’Eure-et-Loir soigne son infrastructure numérique pour mieux couvrir 403 communes et 419 000 habitants en services continus de gestion des transports, d’actions sociales, d’éducation et d’aménagement du territoire. Pour remplacer sa bibliothèque de bandes de 300 Go et faire face à une volumétrie croissante des données, il a retenu deux équipements de sauvegarde sur disques évolutifs, conformes à son PRA (plan de reprise d’activités). Diaga Gueye, responsable des serveurs et de la sauvegarde, précise : “nous avons choisi de placer l’appliance DXi3500 de Quantum, dotée d’une capacité de 4,2 To sur le site de secours, lequel est relié au réseau SAN Fibre Channel de notre site de production, où nous avons installé la bibliothèque Scalar 50 avec lecteurs LTO-4”. Ce dispositif est combiné au logiciel Tina d’Atempo et tire profit des avantages de la déduplication de Quantum. Il protège les fichiers, les bases de données et la messagerie d’une trentaine de serveurs sous Windows et linux. « Après un an d’exploitation, nous constatons un taux de déduplication situé entre 8 et 10”, évalue Diaga Gueye.

Le Conseil Général d’Eure-et-Loir soigne son infrastructure numérique pour mieux couvrir 403 communes et 419 000 habitants en services continus de gestion des transports, d’actions sociales, d’éducation et d’aménagement du territoire. Pour remplacer sa bibliothèque de bandes de 300 Go et faire face à une volumétrie croissante des données, il a retenu deux équipements de sauvegarde sur disques évolutifs, conformes à son PRA (plan de reprise d’activités). Diaga Gueye, responsable des serveurs et de la sauvegarde, précise : “nous avons choisi de placer l’appliance DXi3500 de Quantum, dotée d’une capacité de 4,2 To sur le site de secours, lequel est relié au réseau SAN Fibre Channel de notre site de production, où nous avons installé la bibliothèque Scalar 50 avec lecteurs LTO-4”. Ce dispositif est combiné au logiciel Tina d’Atempo et tire profit des avantages de la déduplication de Quantum. Il protège les fichiers, les bases de données et la messagerie d’une trentaine de serveurs sous Windows et linux. « Après un an d’exploitation, nous constatons un taux de déduplication situé entre 8 et 10”, évalue Diaga Gueye.

Filed under: Terrain | Tagged: déduplication, disques, sauvegarde | Leave a comment »

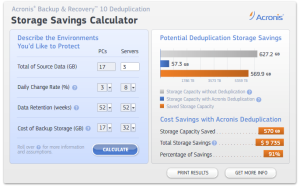

La déduplication reste au coeur des nouveaux enjeux de la sauvegarde et de l’archivage de données professionnelles. Cette technologie réduit les volumes de données transmis, stockés et archivés, en éliminant les doublons de fichiers joints à la messagerie, notamment. Au niveau du système de fichiers, l’administrateur peut écrire ses propres scripts de détection et de purge. Mais à un niveau inférieur, sur les blocs d’une base de données en particulier, cette automatisation devient plus complexe et périlleuse. Il y a quelques jours, EMC soufflait le spécialiste Data Domain à son rival NetApp tandis qu’IBM avalait, fin avril, Diligent Technologies. Sont également en compétition, Exagrid systems, HP, Oracle/Sun et Symantec.

La déduplication reste au coeur des nouveaux enjeux de la sauvegarde et de l’archivage de données professionnelles. Cette technologie réduit les volumes de données transmis, stockés et archivés, en éliminant les doublons de fichiers joints à la messagerie, notamment. Au niveau du système de fichiers, l’administrateur peut écrire ses propres scripts de détection et de purge. Mais à un niveau inférieur, sur les blocs d’une base de données en particulier, cette automatisation devient plus complexe et périlleuse. Il y a quelques jours, EMC soufflait le spécialiste Data Domain à son rival NetApp tandis qu’IBM avalait, fin avril, Diligent Technologies. Sont également en compétition, Exagrid systems, HP, Oracle/Sun et Symantec.

Pas d’investissement sans retour

De son côté, l’éditeur Acronis intègre cette fonctionnalité à son logiciel de sauvegarde. La déduplication peut agir, dans son cas, au niveau de la source ou de la cible, via un module optionnel baptisé Backup & Recovery 10 Deduplication ; son prix oscille entre 22 EUR par station de travail et 190 EUR par serveur.

Pour évaluer les économies permises par le programme, Acronis propose une calculette en ligne (Acronis deduplication ROI calculator). Le simulateur détermine précisément la réduction de la volumétrie et le pourcentage potentiel d’économies, en fonction du nombre de serveurs, de postes de travail et de la fréquence des sauvegardes.

Au-delà du ROI (calcul de retour sur investissement), une autre étude économique sur la déduplication – d’origine Focus Consulting – est reprise en webcast chez Data Domain. Elle identifie quatre sources d’économies liées à cette technologie : les achats de matériels différés, les économies directes, le TCO et les ressources humaines. Et elle signale que le gain principal pour l’entreprise reste au niveau des ressources humaines.

Pas d’automatisation sans réorganisation

Au nom de la récession, peut-on tout se permettre ? Mais non, voyons, aucun fournisseur n’incite ses clients à virer ses administrateurs ; ce serait trop incorrect. Le discours officiel consiste à ré-affecter les responsables de la sauvegarde à des tâches plus gratifiantes, plus innovantes. D’ailleurs, aucun DSI ne songerait à modéliser les salaires chargés de ses collaborateurs (sous forme d’ETP, équivalent temps plein) pour vérifier l’économie totale de sa prochaine solution d’archivage… N’est-ce pas ?

Filed under: Actualités, Tendances | Tagged: économies, déduplication, ROI | Leave a comment »

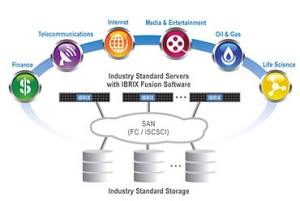

HP poursuit sa croissance externe sur un marché du stockage en net ralentissement cette année. Cette fois, il met la main sur son partenaire Ibrix, déjà retenu pour soulager les traitements 3D des studios d’animation Dreamworks. Avec 175 entreprises clientes et une cinquantaine d’employés, Ibrix fournit une expertise complémentaire à HP dans le Cloud Storage notamment. Son logiciel Fusion complètera l’offre StorageWorks en procurant un chemin d’évolution aux applications traitant de gros volumes de données. Les clients de réseaux SAN et de serveurs à lames HP vont également bénéficier du rapprochement lorsque leur volumétrie croissante ralentit les traitements. Le montant de la transaction n’est pas officiellement révélé, mais HP devrait conclure cette acquisition avant la fin août.

HP poursuit sa croissance externe sur un marché du stockage en net ralentissement cette année. Cette fois, il met la main sur son partenaire Ibrix, déjà retenu pour soulager les traitements 3D des studios d’animation Dreamworks. Avec 175 entreprises clientes et une cinquantaine d’employés, Ibrix fournit une expertise complémentaire à HP dans le Cloud Storage notamment. Son logiciel Fusion complètera l’offre StorageWorks en procurant un chemin d’évolution aux applications traitant de gros volumes de données. Les clients de réseaux SAN et de serveurs à lames HP vont également bénéficier du rapprochement lorsque leur volumétrie croissante ralentit les traitements. Le montant de la transaction n’est pas officiellement révélé, mais HP devrait conclure cette acquisition avant la fin août.

Filed under: Actualités | Tagged: acquisition, Cloud, HPC, stockage | Leave a comment »